@深层词汇假说《Deep lexical hypothesis_Identifying personality structure in natural language》

来源: Cutler, A., & Condon, D. M. (2022). Deep Lexical Hypothesis: Identifying personality structure in natural language.

核心论点 (Deep Lexical Hypothesis)

本文提出了一种利用现代自然语言处理 (NLP) 模型直接从海量自然语言文本中提取人格结构的方法。研究发现,该方法提取的形容词相关性结构与传统问卷调查法的结果高度相似,但信号更强、噪音更少。

核心结论是:自然语言中稳定浮现的是人格的三因素模型(接近于宜人性、外向性、尽责性),而大五模型中的神经质 (Neuroticism) 和开放性 (Openness) 在语言的语义结构中并非顶层因素,其复现性很弱。

1. 引言:现有模型的挑战

- “少数巨头”模型 (The Big Few):

- 例如:大五 (Big Five), HEXACO。

- 优势: 在描述、预测个体生活结果方面非常有效。

- 未解决的问题:

- 普遍性与可复制性: 在非西方文化中,大五结构难以稳定重复。

- 内容遗漏: 为了简约性,模型维度过于抽象和宽泛,忽略了许多重要的人格构念(如幽默、攻击性)。

- 衍生性: 从“少数巨头”向下派生出的细分构面(facet)无法解决根源上的内容遗漏问题。

2. 心理词汇学研究:传统方法 vs. NLP 方法

核心前提:词汇假设 (Lexical Hypothesis)

- 基本思想: 所有重要的人格特质,都已在自然语言的词汇中被编码。

传统心理词汇学方法 (三步流程)

-

第一步:筛选描述词子集 (Subsetting Descriptors)

- 原因: 无法让被试对成千上万个词进行评分。

- 方法: 研究者基于主观判断(如熟悉度、歧义性、相关性)进行人工筛选。

- 弊端: 引入研究者偏见,筛选决策可能严重影响最终的人格结构。

-

第二步:数据收集 (Data Collection)

- 方法: 通过问卷,让大量被试对筛选后的词汇进行自我或他人评分。

- 弊端:

- 样本偏差: 严重依赖 WEIRD (西方的、受过教育的、工业化的、富裕的、民主的) 人群。

- 成本高昂: 耗时耗力,难以进行大规模跨文化研究。

-

第三步:数据降维 (Data Reduction)

- 方法: 对收集到的评分数据进行主成分分析 (PCA) 或因子分析 (Factor Analysis),提取主要维度。

- 弊端

- 线性相关分析方法相对简单,可能忽略复杂关系

- 敏感性分析不足难以评估不同分析方法的影响

- 结果解释受限结果解读依赖于预设理论框架

NLP 方法 (对传统三步流程的革新)

-

第一步:绕过词汇筛选 (Circumventing Subsetting)

- 优势: NLP 模型(如基于 Transformer 架构的模型)通过词嵌入 (word embeddings) 技术,可以轻松处理包含数万甚至更多词汇的完整词库。

- 益处: 避免了人工筛选带来的偏见,分析更全面。

-

第二步:全新的数据来源 (New Data Source)

- 来源: 基于海量的、多样化的公开文本语料库(如网页、书籍、维基百科)进行预训练。

- 优势:

- 规模巨大: 训练数据量比传统调查大数个数量级。

- 成本极低: 可直接使用公开的预训练模型,无需自行收集数据。

- 样本更自然: 数据源于真实世界的使用场景。

- 劣势:

- 贡献文本的个体信息(如人口统计学特征)未知。

- 语料库本身可能存在偏见。

-

第三步:数据生成与分析 (Data Generation & Analysis)

- 方法:

- 提示工程 (Prompt Engineering): 将人格形容词嵌入特定句式(即“提示”或“查询”),输入给预训练模型。

- 向量提取: 模型为每个词生成一个高维度的上下文向量 (contextualized vector),该向量编码了词的语义信息。

- 结构分析: 计算这些向量之间的相关性,再进行主成分分析,其逻辑与传统方法一致。

- 方法:

3. 核心研究:实证探索

本论文通过三个环环相扣的研究,系统地比较了传统问卷法与 NLP 方法在人格结构探索上的异同。

研究 1:复现传统大五结构

- 目标: 确保分析方法的一致性,为后续比较建立基准。

- 数据: 使用 Saucier & Goldberg (1996) 经典的 435 个人格形容词的原始问卷评分数据。

- 方法:

- 进行主成分分析 (PCA) 与 Varimax 旋转 (一种使因子结构更清晰的正交旋转方法)。

- 核心发现:

- 成功复现: 完美重现了原始研究中的大五结构。

- 结构稳健性:

- 前三个因素(宜人性、外向性、尽责性)在提取不同数量的因子时(如从2个到5个)保持高度稳定。

- 第四、第五个因素(神经质、开放性)的出现依赖于Varimax旋转,旋转将第一个主成分的部分方差重新分配给了后面的成分,从而“放大”了它们。

- 结论: 传统数据中,前三个因素的信号最强、最稳固,后两个因素则相对不那么明确。

- 数据准备阶段

- 使用Saucier & Goldberg (1996)的435个人格形容词数据集

- 包含583名被试的自评和他评数据(7/8点量表)

- 对原始数据进行ipsatization处理(消除反应风格差异)

- 每个形容词的评分是一个583维的向量

- 分析阶段

- 取任意两个形容词(如"kind"和"talkative")计算这两个583维评分向量之间的皮尔逊相关系数

- 重复上步计算435个形容词的相关系数矩阵(435×435)

- 进行主成分分析(PCA):

- 先提取10个成分观察特征值

- 保留前5个主成分

- 进行Varimax旋转使结构更清晰

- 比较不同旋转方法和成分数量的效果

- 验证阶段

- 采用两种方法验证结构:

- "倒推法":逐步提取1-5个成分,观察成分稳定性

- 计算Tucker一致性系数,比较不同解决方案的相似性

- 结果验证

- 成功复现了原始研究的Big Five结构

- 发现前2-3个成分最稳定

- 证实Varimax旋转能优化成分解释力

Varimax旋转(方差最大化旋转) 是主成分分析(PCA)或因子分析中常用的一种正交旋转方法,目的是简化因素结构,使结果更易解释。以下是关键点:

1. Varimax旋转的作用

- 核心目标:让每个变量(形容词)尽可能只在一个成分上有高载荷(接近±1),在其他成分上载荷接近0。

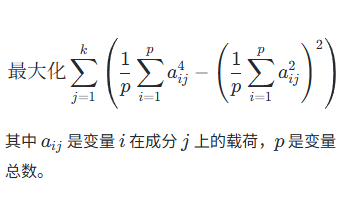

- 数学原理:最大化载荷平方的方差,公式为:

2. 为什么需要旋转?

解决PCA的原始问题:

未旋转的主成分是按方差大小排序的,但成分可能同时代表多个潜在特质(变量在多个成分上均有中等载荷),难以解释。旋转后的优势(如原文结果):

- 更清晰的成分归属:例如旋转后"外向"相关形容词集中在一个成分,而非分散到多个成分。

- 均衡方差解释率:原文中旋转后第1成分的方差从31.7%降至26.8%,第3/4/5成分的方差提升(见图表对比)。

3. 实际效果示例

未旋转的PCA:

可能得到"混合成分"(如一个成分同时包含"外向"和"尽责"的形容词)。Varimax旋转后:

- 成分1:高载荷=健谈、活泼(外向)

- 成分2:高载荷=细致、守时(尽责)

- 其他载荷接近0。

研究 2:NLP 方法与传统方法的首次直接对比

- 目标: 检验 NLP 模型提取的人格结构与传统问卷结构的一致性。

- 核心工具:

- 模型: DeBERTa (一种先进的 Transformer 架构语言模型)。

- 提示 (Query): 设计一个能模拟“他人评价”的句式:

"Those close to me say I have a

[MASK][MASK]and[TERM]personality."[TERM]: 依次填入 435 个形容词。[MASK]: 模型需要预测的“填空”,其生成的向量被用作该形容词的语义表征。(单个MASK会偏向短词常用词, 双MASK能更好捕捉多音节词的完整语义,可以预测带词缀的多音节词)

- 核心发现:

- 结构高度相似:

- NLP 模型生成的形容词相关性矩阵,其方向性 (正/负相关) 与问卷数据高度一致(方向一致性达 96%)。

- 但 NLP 数据的相关性强度显著更高,说明信号更强,噪音更少。

- 大三而非大五:

- 使用未旋转的主成分进行比较时,NLP 模型清晰地复现了问卷数据的前三大因素(一致性系数分别为 0.89, 0.79, 0.79)。

- NLP 模型未能有效复现第四(神经质)和第五(开放性)因素。这两个因素在 NLP 数据中信号微弱,难以解释。

- 语义消歧: NLP 模型能够理解词语在人格描述语境下的特定含义。

- 例如,

transparent(透明的) 的近义词是candid(坦率的),frank(直率的),而非物理上的透明。

- 例如,

- 结构高度相似:

- 结论: NLP 方法能够有效捕捉人格的语义结构,且该结构的核心是三个稳健的维度,与传统方法中最强的信号一致。大五中的后两个维度在自然语言的语义层面并不突出。

研究 3:敏感性分析 (检验方法的稳健性)

-

目标: 探究不同方法学选择(词汇集、提示句式、语言模型)对结果的影响。

-

子研究 3.1: 词汇集的影响 (Descriptor Sets)

- 方法: 使用了三个不同规模的词汇集:

- Webster83: 83个核心人格词汇。

- G&N1710: 1710个常用词汇。

- A&O18k: Allport & Odbert 的近 18,000 个完整词汇。

- 发现: 词汇集的选择对结果影响不大。无论大小,都稳定地复现了与研究二相似的前三大因素结构。

- 方法: 使用了三个不同规模的词汇集:

-

子研究 3.2: 提示句式的影响 (Queries)

- 方法: 设计了 8 种语义不同(如第一人称、反派视角、关系变化)的提示句式。

- 发现: 提示句式的选择影响较小。虽然不同句式会引入一些噪音,但前三大因素结构依然稳健复现。

-

子研究 3.3: 语言模型的影响 (Models)

- 方法: 测试了 18 种不同的预训练语言模型 (如 DeBERTa, RoBERTa, BERT 的不同版本,以及跨语言模型 XLM)。

- 发现: 模型的选择是影响结果的关键因素。

- 大型、先进的模型: 如 DeBERTa, RoBERTa 的大版本,结果最清晰,与传统大五的前三大因素最一致。

- 小型或专用模型: 表现较差。例如,在有毒评论上训练的模型只能提取一个单一的负面评价维度。

- 跨语言模型 (XLM): 在英语和西班牙语的双语测试中,初步显示出区分语言和提取人格维度的潜力,为跨文化研究提供了方向。

4. 总体讨论与理论启示

核心结论

- NLP 方法的有效性: 利用预训练语言模型是研究人格词汇结构的可行且有效的方法。其结果与传统调查法高度一致,但信号更强。

- 对传统方法的验证: 传统问卷调查得到的人格结构在很大程度上反映了词语间的语义关系 (semantic relations),而非仅仅是被试认知图式或行为判断的产物。这为词汇学假设提供了强有力的外部效度证据。

- 人格结构的“大三”核心: 跨越不同分析方法和设置,自然语言中最稳健、最清晰的人格结构是三维的,而非五维。这三个维度与 DeRaad 等人提出的 Affiliation (亲和/宜人性), Dynamism (活力/外向性), 和 Order (秩序/尽责性) 高度重合。

- 神经质与开放性的地位:

- 大五模型中的神经质 (Neuroticism) 和开放性/智慧 (Openness/Intellect) 在语言的顶层语义结构中并不突出。

- 它们在传统研究中的出现,很大程度上依赖于因子旋转这一统计技术,该技术放大了较弱的信号。

- 这并不否认这两个维度作为有效心理构念的存在和重要性,但表明它们可能不属于人格最顶层的、最简约的维度。

5. 未来研究方向与建议

-

深化低阶特质研究:

- 既然顶层结构是三维的,未来的重点应转向利用 NLP 的强大能力,从海量词汇中识别和定义更多低阶 (lower-order)、更具体的特质,建立更全面的“自下而上”的人格分类体系。

- 可以探索聚类分析 (clustering approaches) 等比主成分分析更适合识别细分特质的方法。

-

优化 NLP 技术应用:

- 探索替代性查询策略: 不仅限于“填空”(mask token),还可以分析更复杂的短语、句子,甚至整个段落,以捕捉更丰富的行为、情感和认知信息。

- 推动跨文化研究:

- 利用多语言模型 (multilingual models),可以同时在几十种语言中进行人格结构分析,极大地加速跨文化比较的进程。

- 这有助于解决传统方法在非 WEIRD 地区遇到的困境,并探索真正普遍的人格结构。

-

利用新兴技术:

- 随着语言模型技术的飞速发展(如从处理文本到结合图像/视频的多模态模型 CLIP),未来有可能从更丰富的媒介中提取人格表征。

6. 局限性

- 方法选择的“分叉路径” (Forking Paths):

- 尽管研究检验了多种变量,但仍有许多未探索的方法学决策(如特定的提示工程技巧)可能影响结果。

- 模型选择的局限:

- 仅测试了数千个可用模型中的 18 个。模型的性能受其规模、训练数据和架构的综合影响。

- 偏见问题:

- 语言模型本身可能内含并放大其训练语料库中的社会偏见(如性别、种族歧视),这与问卷调查中的偏见来源不同,但同样需要警惕。

- 语言之外的维度:

- 该方法仅限于通过语言感知的心理差异,无法捕捉那些通过非语言渠道(如肢体语言、面部表情)表达的人格特质。

7. 最终结论

利用现代 NLP 技术研究人格结构是一个充满前景的新领域。它不仅为词汇学假设提供了强有力的支持,还挑战了现有的大五模型在顶层结构上的绝对地位,揭示了一个更简约、更稳健的三因素核心。通过这种低成本、大规模、跨语言的方法,未来的研究有望打破传统调查法的局限,构建一个更全面、更具普遍性的人格科学。